Zombie Agents: Control Persistente de Agentes LLM Auto-Evolutivos

Un nuevo ataque persistente convierte agentes LLM auto-evolutivos en ‘zombies’ comprometidos al inyectar payloads maliciosos en su memoria a largo plazo, manteniendo control entre sesiones.

Think Deep, Not Just Long: Midiendo el Esfuerzo Real de Razonamiento en LLMs

Más tokens no significa mejor razonamiento. Este paper demuestra que lo que importa no es cuánto piensa un LLM, sino cómo: introduce los deep-thinking tokens y el DTR como métrica de esfuerzo real, con correlación positiva robusta frente al rendimiento.

Jailbreaking the Matrix: Cómo Manipular LLMs desde sus Circuitos Internos

HMNS es el primer método de jailbreak que usa interpretabilidad mecanística y geometría de subespacios para manipular directamente los circuitos internos de seguridad de un LLM. Aceptado en ICLR 2026.

Límites de Estabilidad del Razonamiento Autoregresivo: Por Qué los LLMs Fallan en Cadenas Largas

Este paper demuestra matemáticamente que el razonamiento autoregresivo tiene límites intrínsecos de estabilidad: la precisión decae exponencialmente con la longitud de la cadena, independientemente del tamaño del modelo.

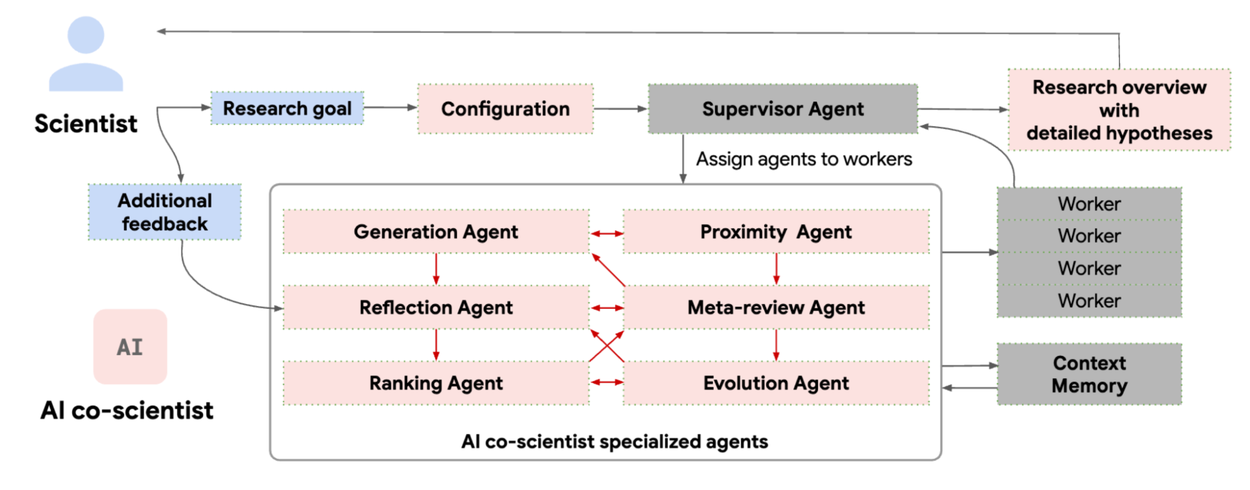

AI Co-Scientist: Google Redefine el Descubrimiento Científico con Agentes Multi-IA

Google presenta un sistema multi-agente basado en Gemini 2.0 que genera hipótesis científicas novedosas y ya ha descubierto tratamientos validados en laboratorio para fibrosis hepática.

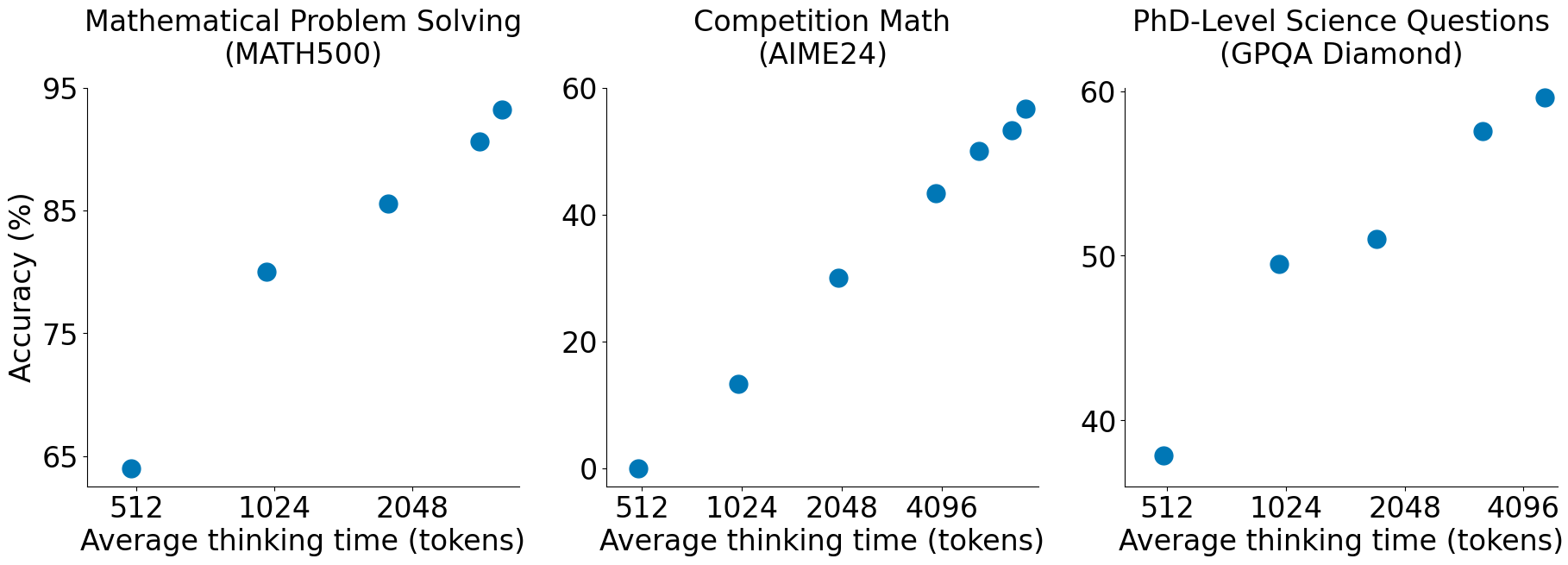

s1: Escalando el Razonamiento con Solo 1,000 Ejemplos y 'Budget Forcing'

Paper de la Semana: s1 (Simple Test-Time Scaling) Paper: s1: Simple test-time scaling Autores: Muennighoff et al. (simplescaling) Publicación: Enero 2026 GitHub: simplescaling/s1 ¿Por qué es relevante? Mientras todos persiguen datasets masivos y clusters de entrenamiento gigantescos, s1 llega con una premisa rompedora: puedes lograr capacidades de razonamiento de vanguardia (SOTA) con solo 1,000 ejemplos de entrenamiento cuidadosamente curados. Este paper desafía la noción de que el razonamiento avanzado es una propiedad emergente exclusiva de modelos entrenados con RL a gran escala (como DeepSeek-R1 o OpenAI o1). En su lugar, demuestran que un modelo fuerte (Qwen2.5-32B) puede “desbloquear” estas capacidades mediante: ...

Agentic World: ¿Son los Agentes una Amenaza o una Revolución?

Un análisis crítico sobre cómo los agentes autónomos redefinen nuestra relación con la tecnología, más allá del código.

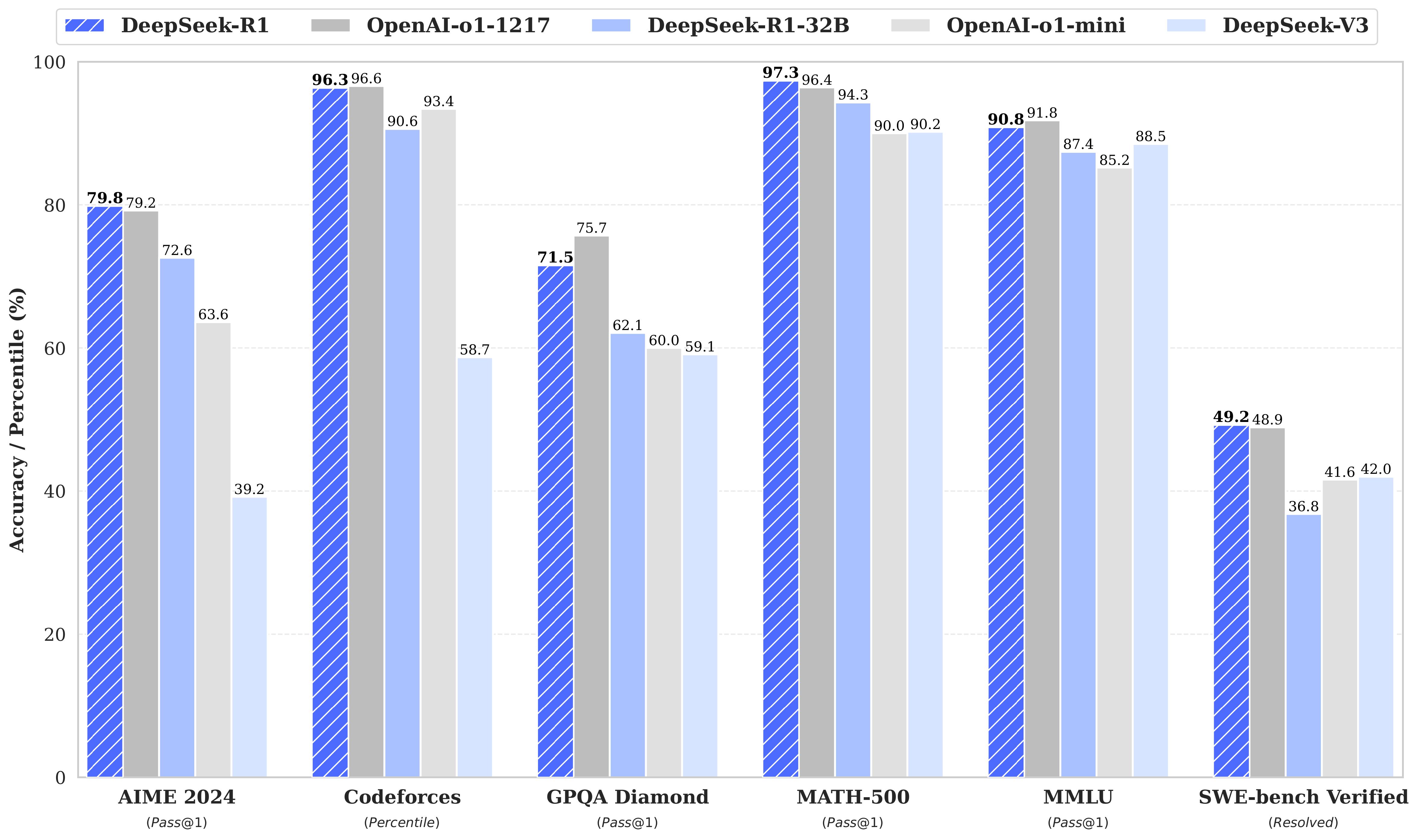

DeepSeek-R1: Revolucionando el Razonamiento en LLMs con Reinforcement Learning Puro

Paper Destacado: DeepSeek-R1 Paper: DeepSeek-R1: Incentivizing Reasoning Capability in LLMs via Reinforcement Learning Autores: DeepSeek-AI Publicación: 22 de enero, 2025 GitHub: deepseek-ai/DeepSeek-R1 ⭐ 91.8k stars ¿Por qué es importante este paper? DeepSeek-R1 representa un hito fundamental en el desarrollo de modelos de razonamiento. Por primera vez, se demuestra que un LLM puede desarrollar capacidades de razonamiento robustas sin necesidad de supervised fine-tuning inicial, utilizando únicamente reinforcement learning (RL) a gran escala. Impacto en la industria Open Source Total: A diferencia de GPT-o1, DeepSeek-R1 es completamente open-source, democratizando el acceso a modelos de razonamiento avanzado Eficiencia Demostrada: Logra performance comparable a OpenAI o1-1217 con una arquitectura y metodología transparente Adopción Masiva: 91.8k estrellas en GitHub en menos de 10 días evidencian el interés de la comunidad Contribuciones Clave 1. DeepSeek-R1-Zero: RL Puro El modelo DeepSeek-R1-Zero se entrena exclusivamente con reinforcement learning, sin ningún fine-tuning supervisado previo. Los resultados son sorprendentes: ...

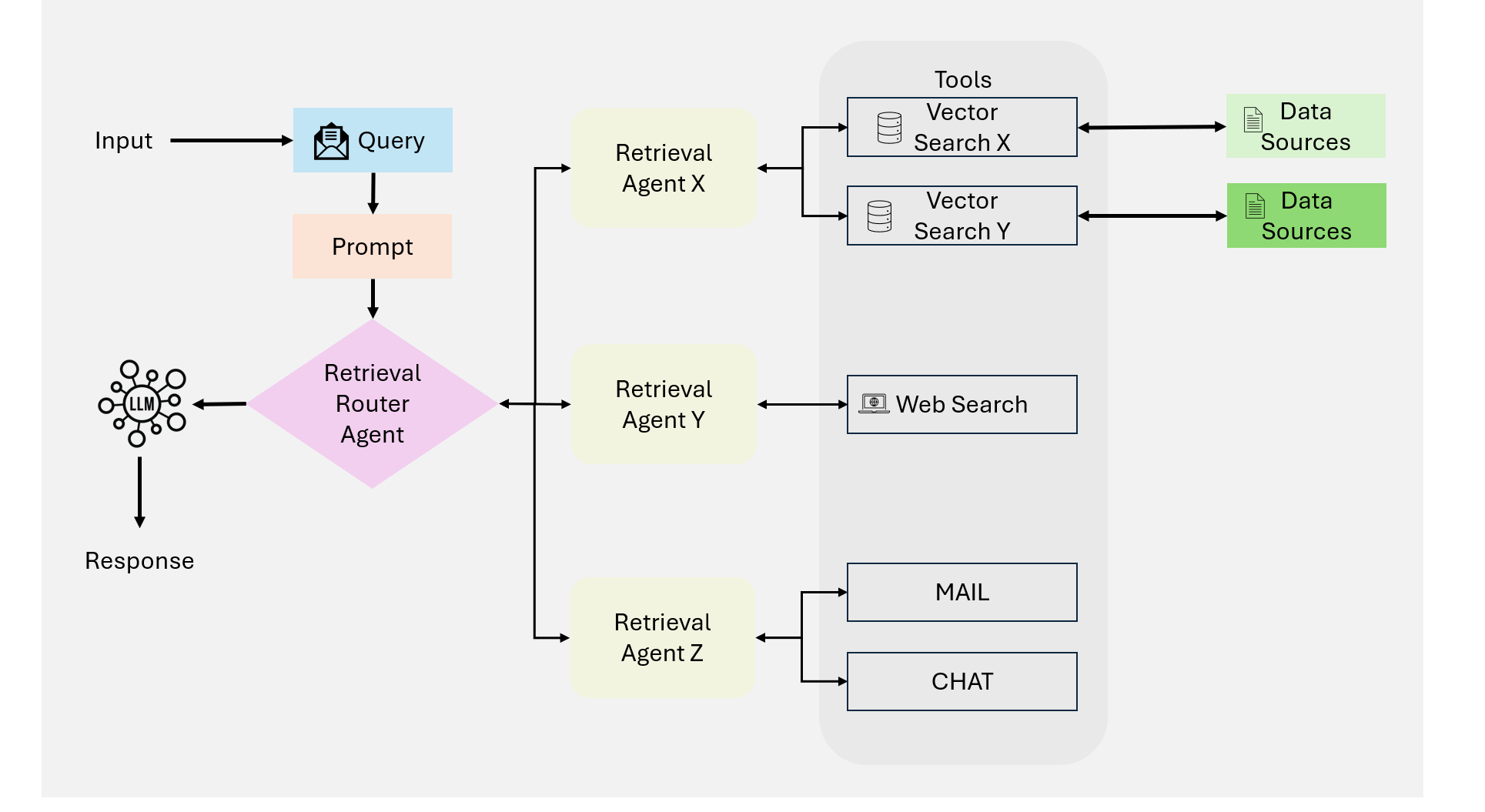

Agentic RAG: La Nueva Generación de Búsqueda Aumentada

Adiós al RAG estático. Los agentes autónomos llegan para razonar, planificar y usar herramientas antes de responder.

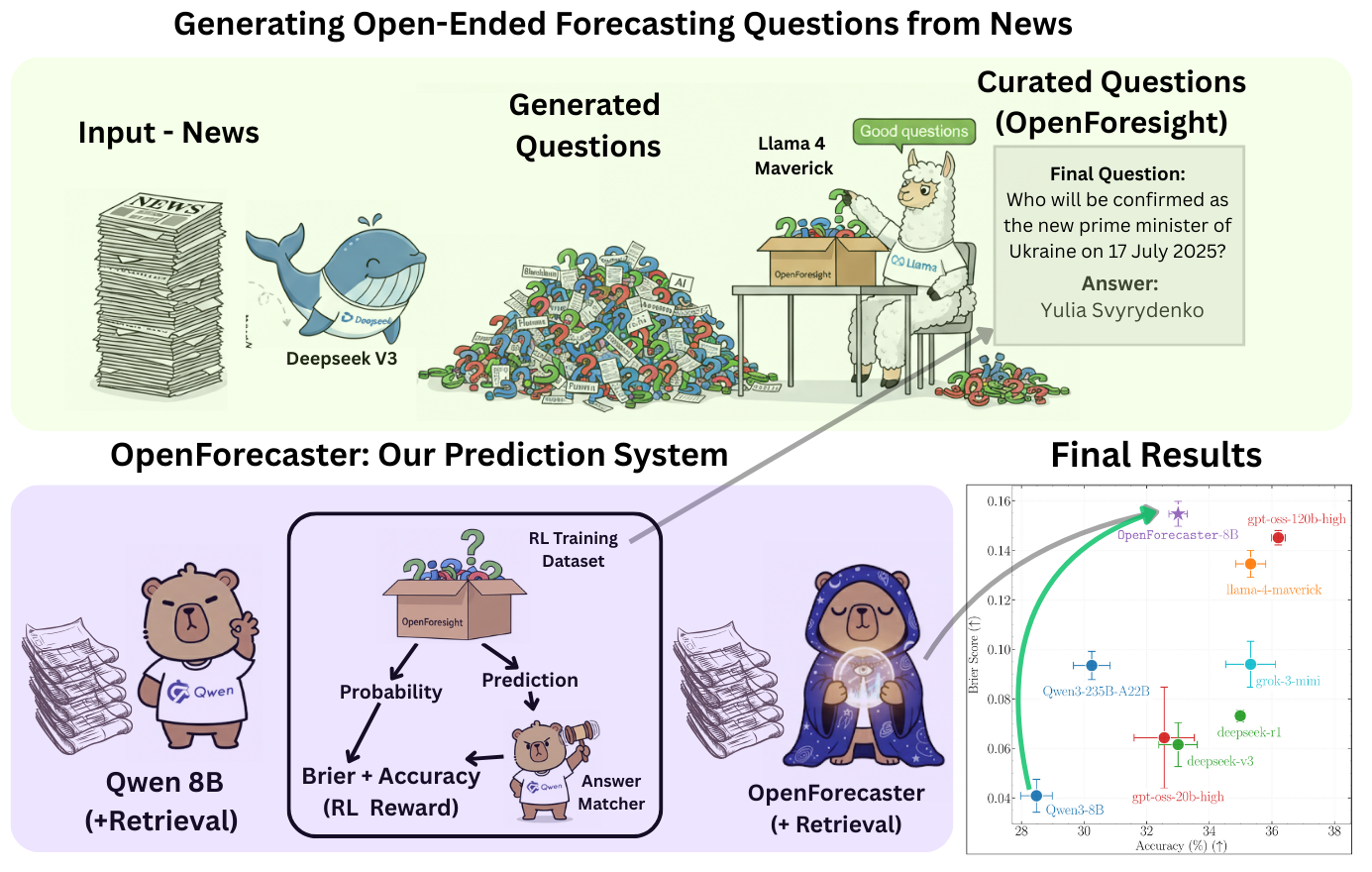

OpenForecaster: Prediciendo el Futuro con Razonamiento Abierto

Un modelo de 8B parámetros que desafía a los gigantes en predicción de eventos futuros mediante razonamiento estructurado.